DeepSeek是这段时间最热门的话题之一,其蒸馏模型可以实现低成本而高质量的推理,使得我们现在可以在本地小型化的硬件上也用上大模型这一AI利器。本文主要介绍通过Ollama来部署DeepSeek R1模型的方法,由于网络环境的问题,过程相比于普通的安装方案可能略有改动。

关于Ollama

Ollama是一个开源工具,专门用于在本地运行、管理和部署大型语言模型(LLMs,Large Language Models)。它简化了 LLMs 的安装、配置和运行流程,支持多种流行的开源模型(如 LLaMA、Mistral、DeepSeek 等),适合开发者和研究人员在本地环境中快速实验和开发。Ollama的官网地址为:https://ollama.com,可以先尝试一下直接从官网下载适合自己本地环境的版本,Linux、Windows和MacOS都有相应的支持。以LINUX为例

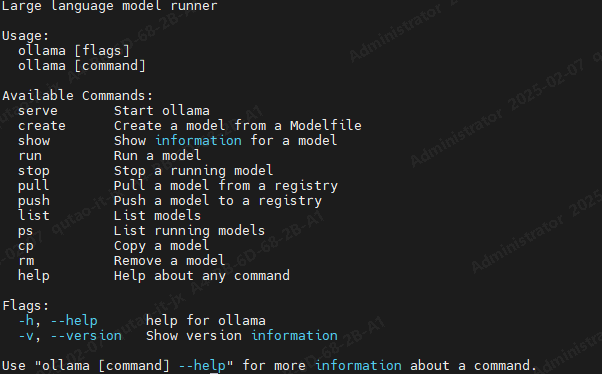

curl -fsSL https://ollama.com/install.sh | sh安装完后,可以使用以下命令查看安装是否成功

ollama --help出现如下结果,说明安装成功

安装DeepSeek-R`1

下面,用Ollama来拉取DeepSeek-R1,我们可以在Ollama官网,查看最新的DeepSeek-R1版本,根据自己的需求和硬件配置,获取对应的版本

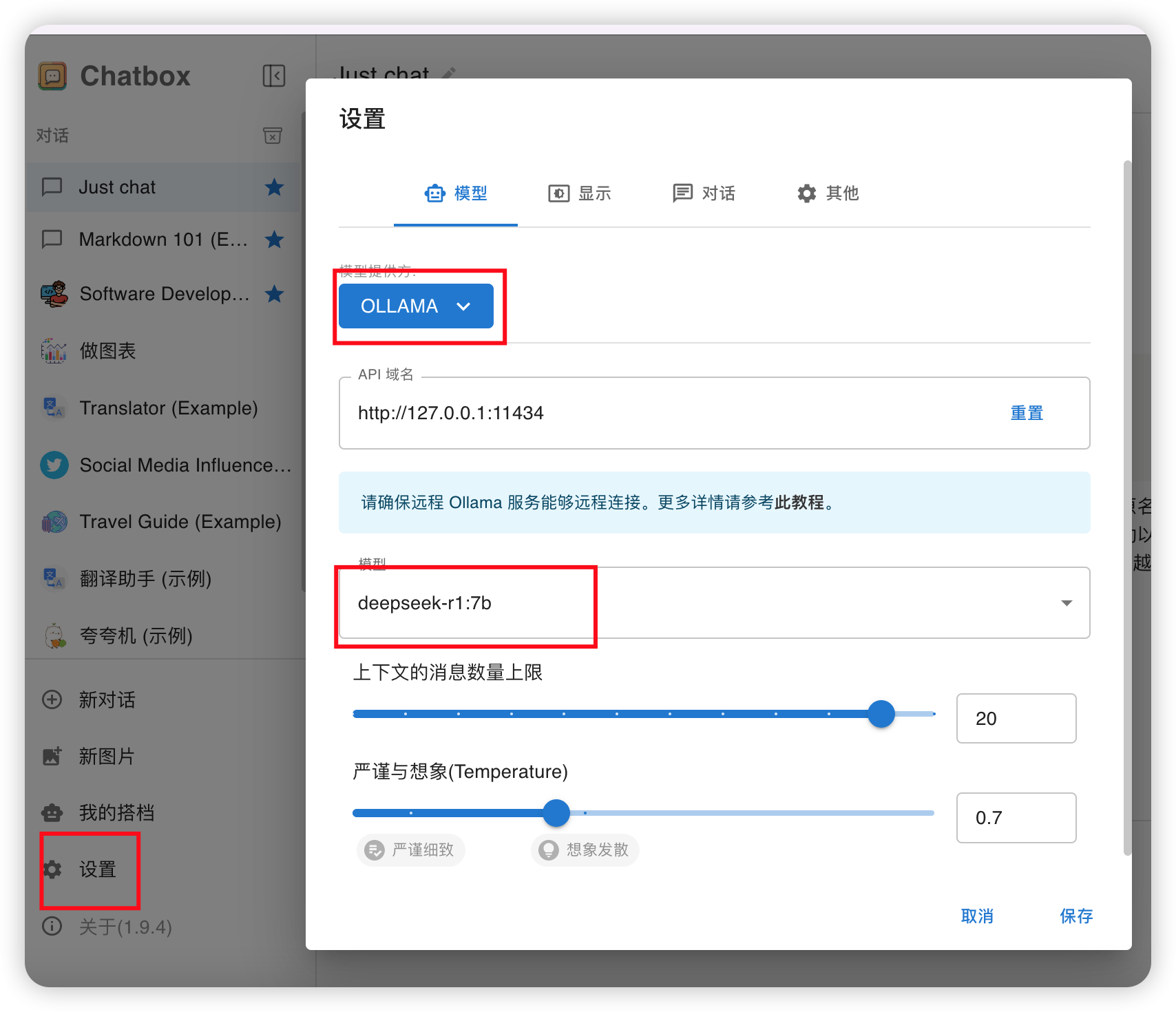

ollama run deepseek-r1:7b安装完毕后,我们就可以用Ollama API来访问DeepSeek-R1模型了,Ollama API的默认端口号是11434,我们可以用http://服务器IP:11434来访问,具体的API文档可以查看Github的官方说明。下面,我们可以用现成的一个Chatbox客户端工具来简单使用API,这个工具有点遗憾,似乎没有可以提供联网搜索的支持

安装Chatbox客户端

在设置中选择ollama,选择deepseekr1模型:

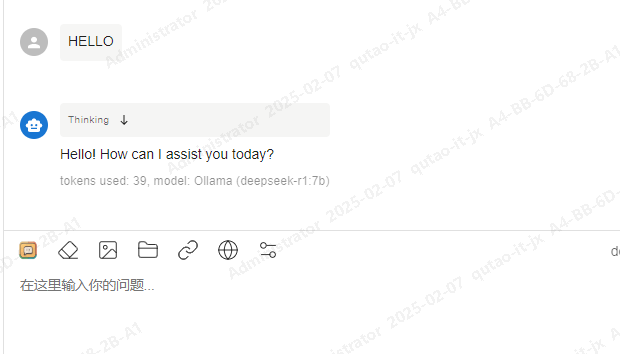

之后就能跟AI愉快的对话了:

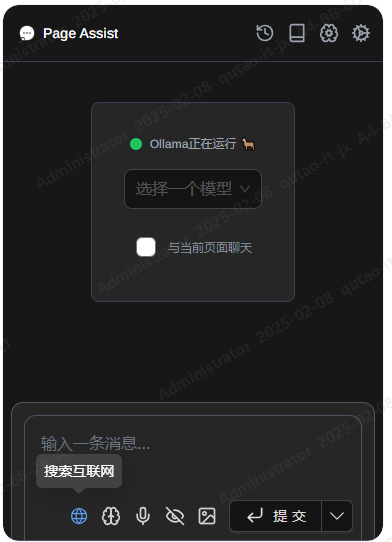

当然,我们也可以用另外一个可以提供联网搜索的工具Page Assist

安装Page Assist

Page Assist 是谷歌(Google)开发的Chrome扩展,旨在帮助用户管理和分析网页内容。它还可以读取本地环境的大模型,并提供搜索支持,从Chrome的拓展市场找到它,安装即可,安装好后,在设置API里面选择Ollama,地址配置成http://服务器IP:11434,选择好对应模型,即可支持联网搜索

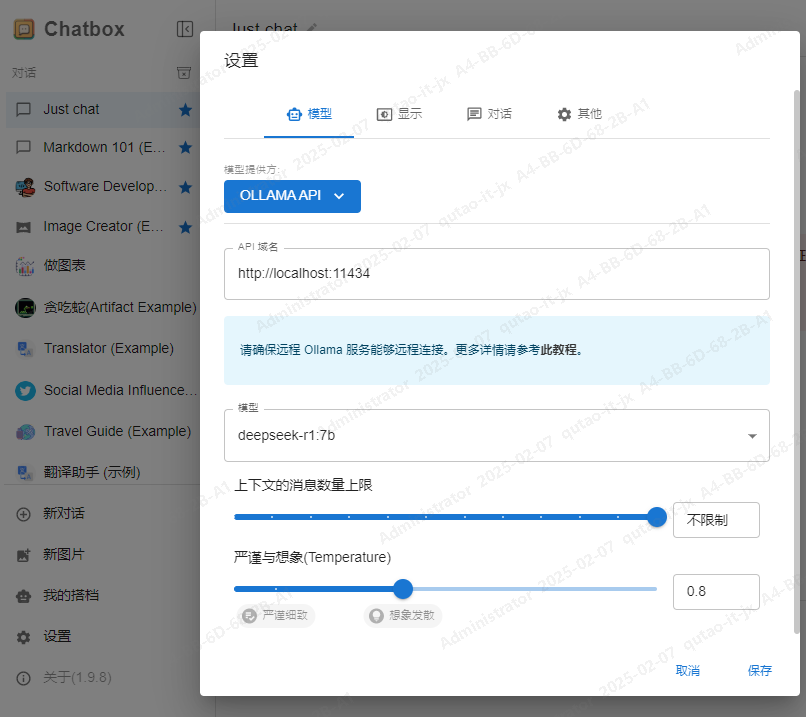

如何在客户端中连接远程 Ollama 服务

除了可以轻松连接本地 Ollama 服务,Chatbox 也支持连接到运行在其他机器上的远程 Ollama 服务。例如,你可以在家中的电脑上运行 Ollama 服务,并在手机或其他电脑上使用 Chatbox 客户端连接到这个服务。你需要确保远程 Ollama 服务正确配置并暴露在当前网络中,以便 Chatbox 可以访问。默认情况下,Ollama 服务仅在本地运行,不对外提供服务。要使 Ollama 服务能够对外提供服务,你需要设置以下两个环境变量:

OLLAMA_HOST=0.0.0.0

OLLAMA_ORIGINS=*在 MacOS 上配置

打开命令行终端,输入以下命令:

launchctl setenv OLLAMA_HOST "0.0.0.0"

launchctl setenv OLLAMA_ORIGINS "*"重启 Ollama 应用,使配置生效。

在 Windows 上配置

在 Windows 上,Ollama 会继承你的用户和系统环境变量。打开控制面板,搜索“环境变量”,为你的用户账户编辑或创建新的变量 OLLAMA_HOST,值为 0.0.0.0; 为你的用户账户编辑或创建新的变量 OLLAMA_ORIGINS,值为 *。点击确定/应用以保存设置。

在 Linux 上配置

如果 Ollama 作为 systemd 服务运行,应使用 systemctl 设置环境变量:

调用 systemctl edit ollama.service 编辑 systemd 服务配置。这将打开一个编辑器。

systemctl edit ollama.service在 [Service] 部分下为每个环境变量添加一行 Environment:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"保存并退出。重新加载 systemd 并重启 Ollama:

systemctl daemon-reload

systemctl restart ollama